-

振东集团的”本草革命”:让中药材跳出药罐子,闯出大健康新天地

发布时间:2025/06/10

红球纷飞传三晋,大爱无边漫九州。5月25日,由中国红十字会总会主办,山西振东健康产业集团赞助的“红气球挑战赛”(晋中站)在山西省高校新区(山西大学城)鸣笛开赛。该赛事汇聚了来自全国各地及山西大学城高校的...

-

2025中美领衔世界级艺术名家 ——赵玉林精品展播

发布时间:2025/01/17

赵玉林,笔名三友,内蒙古包头市美术家协会副主席,草原书画院院长,中国美协内蒙古分会会员,台北故宫书画院名誉院长,中华国礼书画家,国家博物馆画廊特邀书画家。作品入选《中国当代国际书画家年鉴》,在中国书画研究...

-

腾讯创作者生态的前车之鉴,能否支撑《元梦之星》逐梦UGC?

发布时间:2023/09/24

近期,腾讯以“天美乐园”的特别形式公布了新作《元梦之星》,宣告正式入主派对游戏赛道。过去,派对游戏在国内市场份额较小,直到《糖豆人》《香肠派对》《蛋仔派对》等作品引发用户和市场的高度关注,整个赛道才...

-

普悦智能,专注净水,为渠道经销搭载新引擎!

发布时间:2023/08/28

稳步推进:祝贺普悦智能(北京联营公司)第一轮股东入股签约圆满成功! 2023年8月18日,浙江普悦智能科技有限公司北京联营公司——北京普悦京允智能科技有限公司在总经理宋玉财的热忱推进下,成功签约了五名销售/服...

-

英国与快速反应小组一起抗击冠状病毒

发布时间:2020/04/01

英国政府宣布了新的措施,以打击虚假的COVID-19在线信息的传播,包括建立专门的专家小组来处理错误信息。 新成立的快速反应小组将在英国内阁办公室内部运作,并将研究应对互联网上“有害叙述”的方法-解决“...

-

微软即将吸引消费者-但Skype仍将保留

发布时间:2020/03/31

微软今天宣布,今年晚些时候,它将推出Teams的基本消费版,即类似于Slack的文本,音频和视频聊天应用程序。就像Microsoft所喜欢的,您的个人生活团队将使用许多工具,这些工具将使家庭和小组更轻松地组织...

-

安全漏洞暴露了共和党选民公司的内部应用代码

发布时间:2020/03/31

一家专供共和党政治运动使用的选民联系和拉票公司,错误地在其网站上留下了未经保护的应用程序代码副本,供任何人找到。 Campaign Sidekick公司通过iOS和Android应用程序帮助共和党竞选活动布署其选区,这...

-

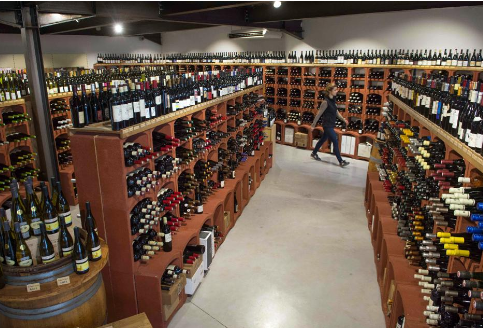

在宾夕法尼亚州,州酒商店仍然关闭,人们越来越口渴

发布时间:2020/03/31

随着美国人渴望长时间的自我隔离,白酒业务的销量激增。根据尼尔森(Nielsen)的数据,到3月中旬,这一增长已经比去年同期高出26%以上。但是,联盟中至少有一个州与这种趋势背道而驰,而且与消费者的意愿无...

微软训练世界上最大的Transformer语言模型

发布时间:2020/02/11 新闻 浏览次数:907

微软AI&Research今天分享了有史以来最大的基于Transformer的语言生成模型,并开源了一个名为DeepSpeed的深度学习库,以简化对大型模型的分布式培训。

图灵NLG的参数为170亿个,是英伟达的Megatron(现在是第二大变形金刚机型)的两倍,其参数是OpenAI的GPT-2的十倍。 Turing NLG在一系列NLP任务上均达到了最新水平。

像Google的Meena一样,最初使用GPT-2,图灵NLG最初只能在私人演示中共享。

具有Transformer架构的语言生成模型可以预测下一个单词。它们可用于编写故事,以完整的句子生成答案以及总结文本。

来自AI领域的专家告诉VentureBeat 2019,这是使用Transformer架构的NLP模型开创性的一年,这种方法导致语言生成和GLUE基准测试领导者如Facebook的RoBERTa,Google的XLNet和Microsoft的MT-DNN取得了进步。

也是今天:Microsoft开源DeepSpeed,这是一个深度学习库,为开发人员进行了优化,可提供低延迟,高吞吐量的推断。

DeepSpeed包含零冗余优化器(ZeRO),可用于大规模训练具有1亿个或更多参数的模型,Microsoft曾用它训练Turing NLG。

微软AI研究应用科学家科比·罗塞特(Corby Rosset)写道:“除了通过汇总文档和电子邮件来节省用户时间之外,T-NLG还可以通过为作者提供写作帮助并回答读者可能对文档提出的问题来增强Microsoft Office套件的体验。今天的博客文章。

开发人员和机器学习从业人员都可以使用DeepSpeed和ZeRO,因为培训大型网络(例如使用Transformer架构的网络)可能会很昂贵,而且可能会遇到大规模问题。

在其他自然语言AI新闻中,Google的DeepMind今天发布了Compressive Transformer远程内存模型和PG19,这是用于分析书本长度语言生成性能的基准。